Le deep learning au microscope de Luc Julia

Podcast: Play in new window | Download (Duration: 12:39 — 11.6MB)

Subscribe: Apple Podcasts | Spotify | Android | Blubrry | Email | RSS | More

Deep Learning : un vocable utilisé fréquemment depuis quelques années que l’intelligence artificielle est (re)devenue à la mode. Mais qu’est-ce qu’exactement que le Deep Learning ? Comment dissocier Deep Learning et Machine Learning ? Et surtout, à quoi cela sert-il ? Pour le savoir, j’ai demandé à Luc Julia, auteur du récent livre à succès « l’intelligence artificielle n’existe pas » de répondre à mes quelques questions. Pour cette interview je n’ai pas désiré revenir sur le thème principal du livre, largement débattu dans la presse et dans les blogs (je vous conseille la vidéo suivante). J’ai voulu au contraire profiter de la compétence et de l’expertise d’un vétéran de l’intelligence artificielle dans la Silicon Valley pour regarder le côté positif des choses et bien circonscrire le sujet. Ce billet est préparé dans la perspective du salon AI Paris 2019, dont Visionary Marketing est partenaire média et qui aura lieu les 11 et 12 juin prochains au Palais des Congrès de la capitale.

Le Deep Learning : qu’est-ce que c’est et à quoi ça sert ?

Luc Julia « vit depuis vingt ans dans la Silicon Valley, est l’un des pères de Siri, l’assistant vocal de l’iPhone, a travaillé chez Apple, puis Samsung, où il est l’un des rares non coréens à occuper un poste de vice-président » nous apprennent Les Echos.

Il a eu pour professeur Jean-Gabriel Ganascia, auteur du « mythe de la singularité », dont j’ai déjà évoqué le livre dans ces colonnes, et qui a la particularité d’être philosophe, outre son statut d’expert en IA. Ici, j’ai voulu me focaliser sur un sujet un peu mystérieux, le Deep Learning, que j’ai demandé à Luc de définir.

L’Histoire de l’IA pour expliquer le Deep Learning

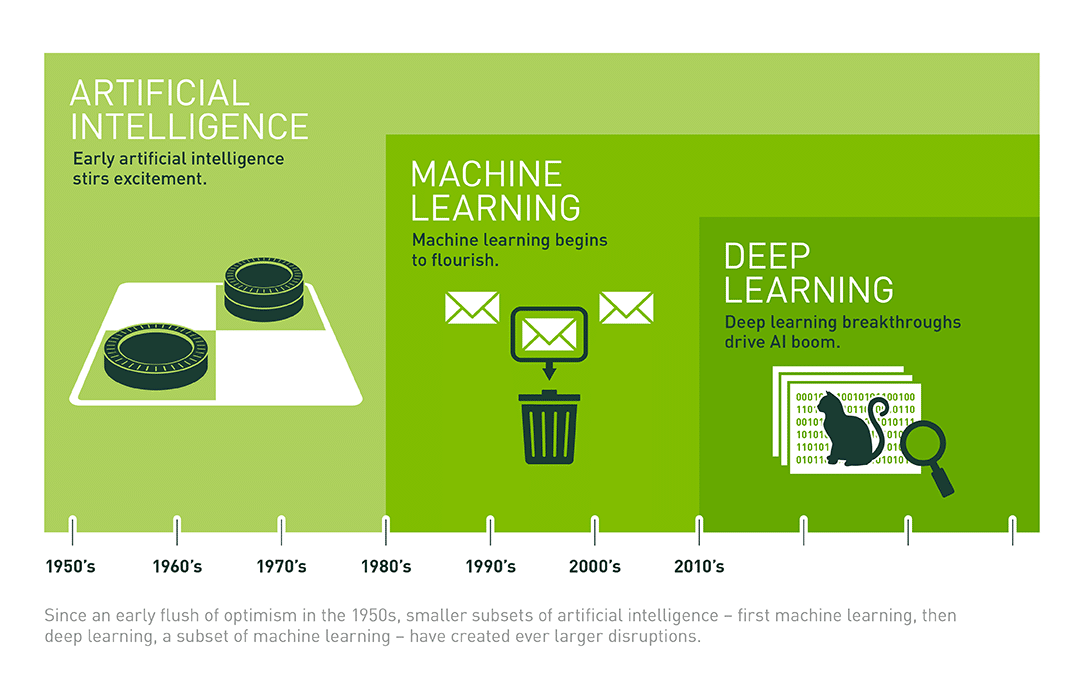

Il faut faire un peu d’histoire pour expliquer comment ça marche. Il faut comprendre comment ce concept est venu dans l’histoire de l’intelligence artificielle dans les soixante dernières années. Avec l’intelligence artificielle, on a commencé par essayer de modéliser le cerveau. Or bien vite, dès les années 50, on s’est aperçu que c’était très compliqué et qu’on n’y arriverait pas. On est donc passé aux systèmes experts. Puis on est arrivé aux réseaux de neurones, qui est aussi ce qu’on appelle me Machine Learning.

Ça a commencé vraiment à marcher dans les années 80, puis, dans les années 2000, on a observé une évolution du machine learning vers ce qu’on appelle désormais le deep learning. C’est une évolution de ces réseaux de neurones.

Comment décrire les réseaux de neurones ?

Les réseaux de neurones sont une approximation statistique d’un problème quel qu’il soit. Tout part du grand nombre de données disponibles. C’est pour cette raison que le machine learning et le deep learning se sont développés beaucoup après l’apparition d’Internet. Le déclic s’est fait aussi avec l’arrivée des Big Data.

En machine learning, on prend des données, puis on va les labelliser avec étiquettes pour décrire la donnée avec des paramètres qui la décrivent le mieux possible. Les Data Scientists vont regarder ces données et les labelliser en leur attribuant des paramètres et des caractéristiques. On va ensuite utiliser des méthodes statistiques pour décrire le problème. Puis on crée ce qui s’appelle un modèle qui sera réutilisé la prochaine fois que l’on rencontre un problème similaire.

Le deep learning est très similaire mais avec une étape de moins, ou une étape de plus, selon la façon dont on regarde les choses. L’étape de moins c’est l’abandon de la labellisation des données, car elles vont se labelliser toutes seules. Cela signifie que l’on va créer un système qui va trouver ses propres paramètres (ceux dont nous parlions tout à l’heure pour le machine learning). Ceux-ci ne seront plus attribués par des data scientists qui définissaient le problème.

On y arrive en alimentant la machine avec une masse de données, et en lui demandant de trouver elle même des paramètres en les organisant en plusieurs couches de neurones. En général, il n’y avait qu’une ou deux couches dans les réseaux de neurones du machine learning, avec le Deep Learning, il y aura une multitude de couches.

Quand un humain va regarder les paramètres qui ont été trouvés par la machine pour décrire un problème, il n’est pas certain qu’il comprenne la logique de ces paramètres. Cela veut dire simplement que les calculs mathématiques qui sont faits pour trouver automatiquement ces labels ou étiquettes ne sont pas compatibles avec une logique humaine puisque justement, aucun humain n’intervient dans ce processus. A chaque fois que l’on rajoute des données, les paramètres sont recalculés automatiquement. .

Quelques applications du deep learning

Le Deep Learning est arrivé au milieu des années 2000 et a véritablement explosé dans les années 2010. La première application en a été la reconnaissance d’images. On donne une image à manger à l’ordinateur, et celui-ci va la classifier et va en déduire qu’il s’agit d’un chat, un chien ou une vache, etc. Cela marchait déjà très bien déjà avec le machine learning mais le résultat était encore bien meilleur avec le Deep Learning. Cela s’explique par l’abondance de modèles d’images.

Un autre domaine dans lequel cette technologie s’est appliquée avec de très bons résultats, et où les progrès récents (une dizaine d’années) ont été spectaculaires, est celui de la reconnaissance de la parole et de la traduction automatique, par exemple. Ce n’est pas encore parfait, mais cela marche beaucoup mieux que par le passé, il suffit en quelque sorte de nourrir le système en données.

Que peut-on imaginer comme applications dans le futur et qui sont assez positives

Je crois énormément à l’application du machine learning et du deep learning dans le domaine de la médecine qui est un domaine où on a énormément de données à exploiter. Prenons l’ADN en exemple, c’est statistiquement très intéressant du fait de l’énorme masse des séquences de données. On peut imaginer qu’avec ces technologies d’IA on va pouvoir récupérer toutes les données d’humains malades ou en bonne santé, et créer des modèles pour savoir si on observe des dégénérescence ou des mutations, avant même qu’elles arrivent.

Citons aussi l’imagerie médicale visuelle. On peut appliquer ce qu’on a réalisé pour reconnaître des images d’animaux à la reconnaissance du cancer du sein par exemple. On peut fournir des millions d’images de cancers du sein différents à une machine, bien labellisés par des médecins ou non, et cette machine en saura forcément beaucoup plus que ce qu’aucun médecin, aussi bon soit-il, aura jamais vu au cours de sa carrière.

Ce seront des aides extraordinaires. Uniquement des aides car l’intelligence artificielle n’est qu’un outil. En fin de compte, c’est l’humain qui a la main sur ce que fait le système.

Prenons ensuite le domaine de la voiture autonome. A partir des données statistiques générées par les voitures en roulant, on peut imaginer que les voitures puissent de plus en plus pouvoir réagir seules dans des cas où la rapidité est cruciale et l’humain n’aurait pas eu la rapidité nécessaire.Donc ces systèmes de vision (par radars ou lidars ou caméras) sont aussi des systèmes de reconnaissance d’images qui vont augmenter l’autonomie des véhicules. Toutefois, je ne pense pas personnellement qu’avec ces techniques statistiques actuelles une voiture puisse être autonome à 100% (au niveau 5 comme le disent les spécialistes).

Une discipline encore balbutiante

Nous en sommes toujours aux balbutiements de cette discipline qui n’a qu’une dizaine d’années. Dans le futur on trouvera davantage de champs d’application. Mais ce sur quoi il faut être très précis et clair c’est que ces systèmes vont être compartimentés. On parle souvent de l’intelligence artificielle généralisée mais cela n’existera pas car des systèmes statistiques ne pourraient se rapprocher du fonctionnement de nos cerveaux avec leur diversité. Donc, il ne faut pas penser que l’intelligence artificielle va nous remplacer, il est très important de le répéter et j’ai écrit le livre pour expliquer cela.

Par contre dans chacun de ces champs d’application possibles on observera des progrès fabuleux dans les années qui viennent.

- Drive to Zero 2024, des nouvelles mobilités à la démobilité - 18/04/2024

- Web crash : le web va-t-il disparaître ? - 17/04/2024

- Marketing B2B et B2C : différences et similitudes - 11/04/2024